LLMForEverybody

什么是大模型复读机问题

人类的本质是复读机

LLMs复读机问题是指这些模型在生成文本时倾向于重复之前说过的内容或者重复某些常见的表达方式,而不是产生新颖或多样化的输出,这种现象在微调开源大模型时尤为常见。

具体表现

-

重复单词或短语:模型可能会在生成的文本中重复使用相同的单词或短语,尤其是在没有足够上下文的情况下;

-

重复主题或观点:在讨论某个话题时,模型可能会重复已经表达过的观点,而不是提供新的见解或信息;

-

模仿风格:模型可能会模仿训练数据中的风格或语调,而不是根据当前的上下文创造新的风格;

-

缺乏创新:由于模型的训练目标通常是预测下一个最可能的单词或短语,它们可能更倾向于生成安全、常见的文本,而不是创新或独特的内容.

解决策略:

微调策略

多样化训练数据:确保模型训练时使用的数据具有多样性,避免过度依赖某些特定的文本或风格;

生成策略

改进生成策略:通过调整生成过程中的参数,如温度(temperature)或顶层采样(top-k sampling),鼓励模型产生更多样化的输出;

Prompt工程

上下文管理:提供丰富和相关的上下文信息,帮助模型更好地理解当前的任务,并生成更有意义的回答;

后处理(兜底策略)

后处理:在生成文本之后,通过后处理步骤来检测和减少重复内容.

在企业应用中,当我们fine-tuning一个开源模型的时候,很多情况下,我们的数据数量和质量都不是很好,而硬件资源限制了我们只能选择较小的模型,试图做一个领域大模型,这时候就会很容易遇到大模型复读机问题.

问题的本质-智能涌现失败

大模型的本质是next-token prediction,是一个语言模型,而大模型之所以能冠以智能呢个,是因为它出现了智能涌现.

涌现

Emergence

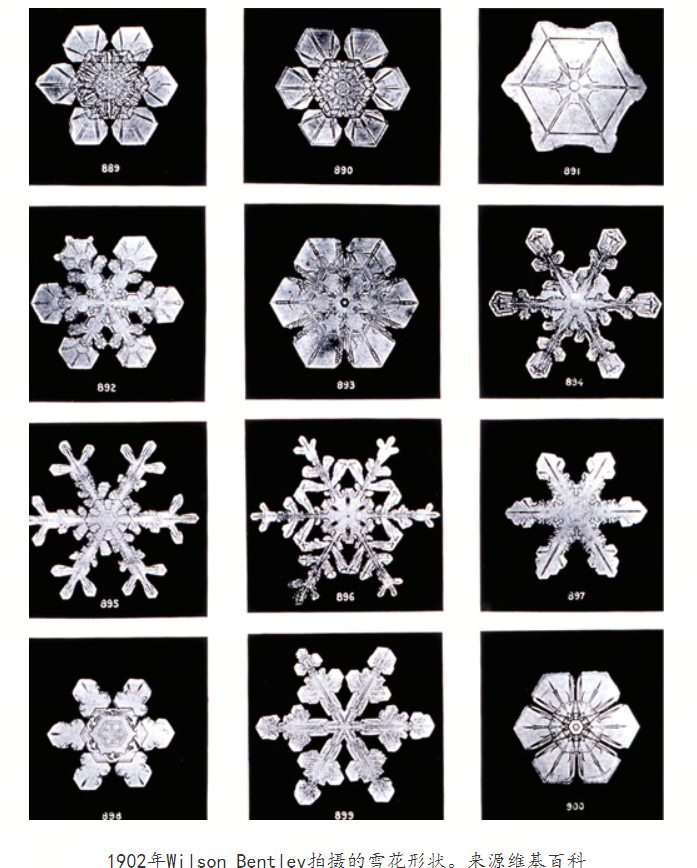

涌现是指在复杂系统中,由大量简单个体的相互作用产生的不可预测的、新的模式或行为。

雪花的形成是一个很好的例子,展示了自然界中涌现现象的美丽和复杂性:单个水分子是简单的,但当无数的水分子在大气中遇到冷空气并开始结晶时,它们会自发地组织成复杂的、具有特定对称性的雪花晶体结构。

其他涌现现象的例子还包括蚁群的行为、鱼群的集群、鸟群的飞行模式等,这些都是从简单的个体行为中产生的复杂集体现象。

智能涌现

Intelligence Emergence

智能涌现是复杂系统科学中的一个核心概念,它描述的是在一个系统中,当大量简单的个体以一定方式相互作用时,会自发产生新的、不可预测的特性或行为。这些新特性不是单个个体所具有的,而是系统整体的属性。

在人工智能领域,智能涌现通常指的是随着AI模型规模的增大,如参数数量的增加,模型开始展现出一些预先没有被明确编程的能力或行为。

智能涌现的特点包括自适应、创新和复杂性。例如,大型语言模型如GPT-3在训练后能够展现出令人惊讶的创作能力,如写诗、编写文章甚至生成代码,这些能力并非在训练数据或程序中明确指定,而是从大量数据中自主学习得到的。

在GPT-3之前,人们可能很难想象一个AI模型能够如此自如地进行自然语言生成,但随着模型规模的增大和训练数据的增加,这种智能涌现的现象变得越来越普遍。

参考

欢迎关注我的GitHub和微信公众号,来不及解释了,快上船!

仓库上有原始的Markdown文件,完全开源,欢迎大家Star和Fork!